揭秘Llama2中文大模型:国内首个领先版本发布

作者:FlagAlpha

来源:Llama中文社区

图片来源:由无界 AI生成

导语

7月31日,Llama中文社区率先完成了国内首个真正意义上的中文版Llama2-13B大模型,从模型底层实现了Llama2中文能力的大幅优化和提升。毋庸置疑,中文版Llama2一经发布将开启国内大模型新时代!

| 全球最强,但中文短板

Llama2是当前全球范围内最强的开源大模型,但其中文能力亟待提升

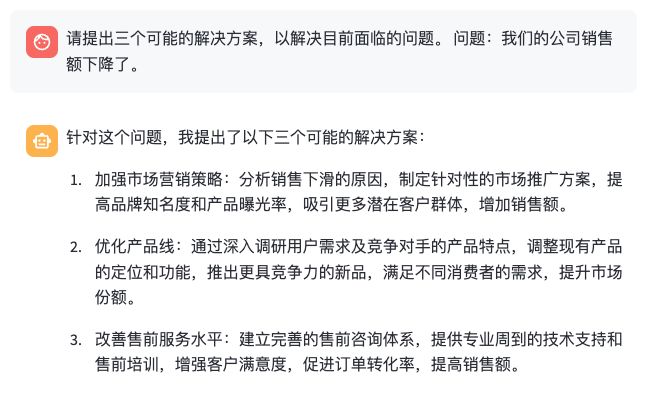

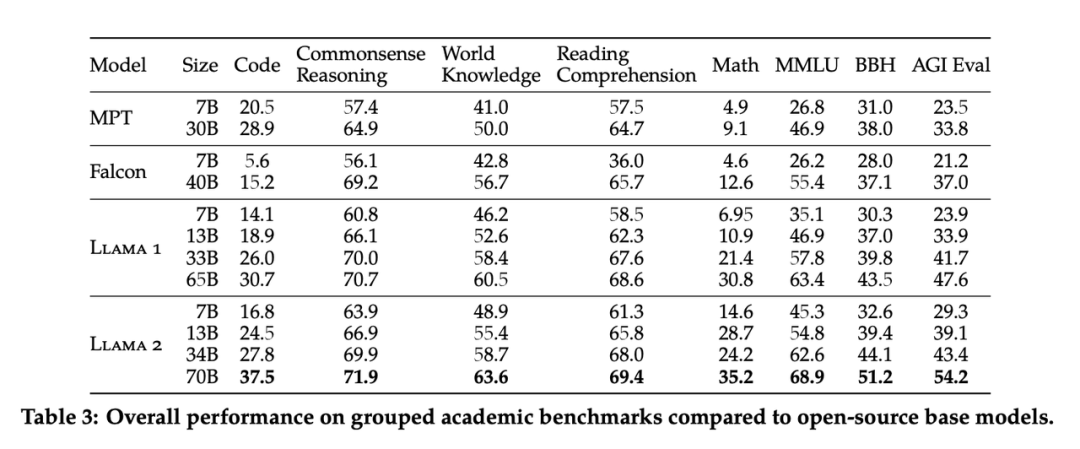

作为AI领域最强大的开源大模型,Llama2基于2万亿token数据预训练,并在100万人类标记数据上微调得到对话模型。在包括推理、编程、对话和知识测试等许多基准测试中效果显著优于MPT、Falcon以及第一代LLaMA等开源大语言模型,也第一次媲美商用GPT-3.5,在一众开源模型中独树一帜。

虽然Llama2的预训练数据相对于第一代扩大了一倍,但是中文预训练数据的比例依然非常少,仅占0.13%,这也导致了原版Llama2的中文能力较弱。

我们对于一些中文问题进行提问,发现大多数情况下Llama2都不能以中文回答,或者以中英文混杂的形式回答问题。因此,需要基于大规模中文数据对Llama2进行优化,使Llama2具备更好的中文能力。

为此国内顶尖高校大模型博士团队创办了Llama中文社区,开启了Llama2中文大模型训练征程。

| 最领先的Llama中文社区

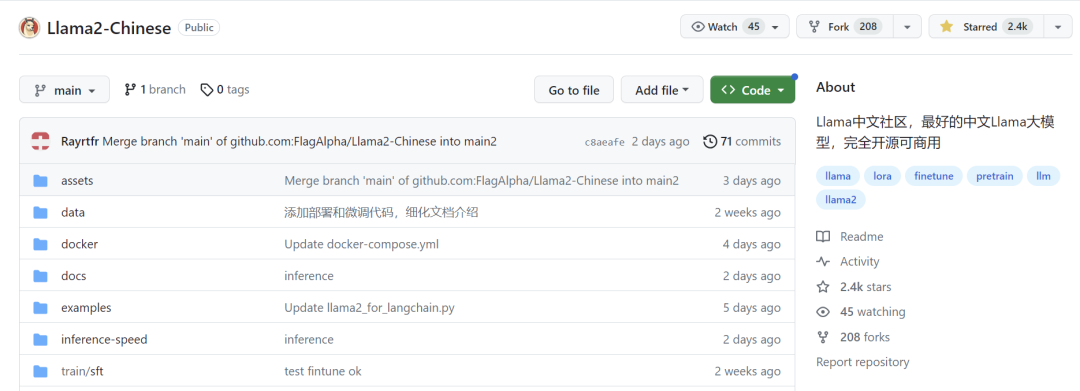

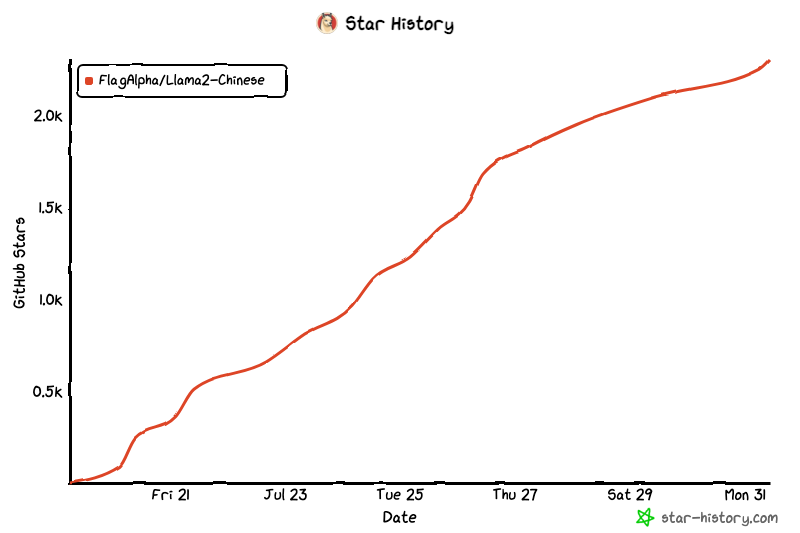

Llama中文社区是国内最领先的开源大模型中文社区,Github达到 4.7k star,由清华、交大以及浙大博士团队领衔,汇聚了60+AI领域高级工程师以及各行业2000+顶级人才。

社区链接:

https://github.com/FlagAlpha/Llama2-Chinese

社区历程:

| 首个预训练中文Llama2大模型!

不是微调!而是基于200B中文语料从头训练!

Llama中文社区是国内首个完成真正意义上的中文版13B Llama2模型:Llama2-Chinese-13B,从模型底层实现了Llama2中文能力的大幅优化和提升。

Llama2的中文化可以采用大致两种路线:

- 基于已有的中文指令数据集,对预训练模型进行指令微调,使得基座模型能够对齐中文问答能力。这种路线的优势在于成本较低,指令微调数据量小,需要的算力资源少,能够快速实现一个中文Llama的雏形。

但缺点也显而易见,微调只能激发基座模型已有的中文能力,但由于Llama2的中文训练数据本身较少,所以能够激发的能力也有限,治标不治本,从根本上增强Llama2模型的中文能力还是需要从预训练做起。

- 基于大规模中文语料进行预训练。这种路线的缺点在于成本高!不仅需要大规模高质量的中文数据,也需要大规模的算力资源。但是优点也显而易见,就是能从模型底层优化中文能力,真正达到治本的效果,从内核为大模型注入强大的中文能力!

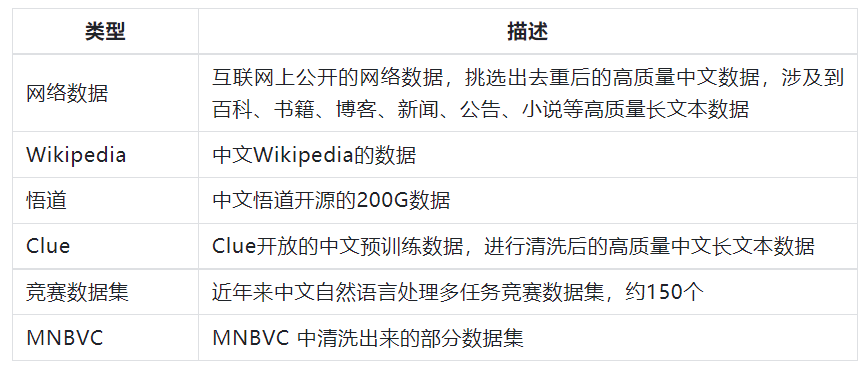

为了从内核实现一个彻底的中文大模型,我们选择了第二条路线!我们汇集了一批高质量的中文语料数据集,从预训练开始优化Llama2大模型。部分预训练数据数据如下:

首期 Llama2-Chinese-13B 模型的预训练数据包含 200B token,未来,我们将持续不断地迭代更新 Llama2-Chinese,逐步将预训练数据提升到1T token。除此以外,我们也将逐步开放70B模型的中文预训练版本,敬请期待!

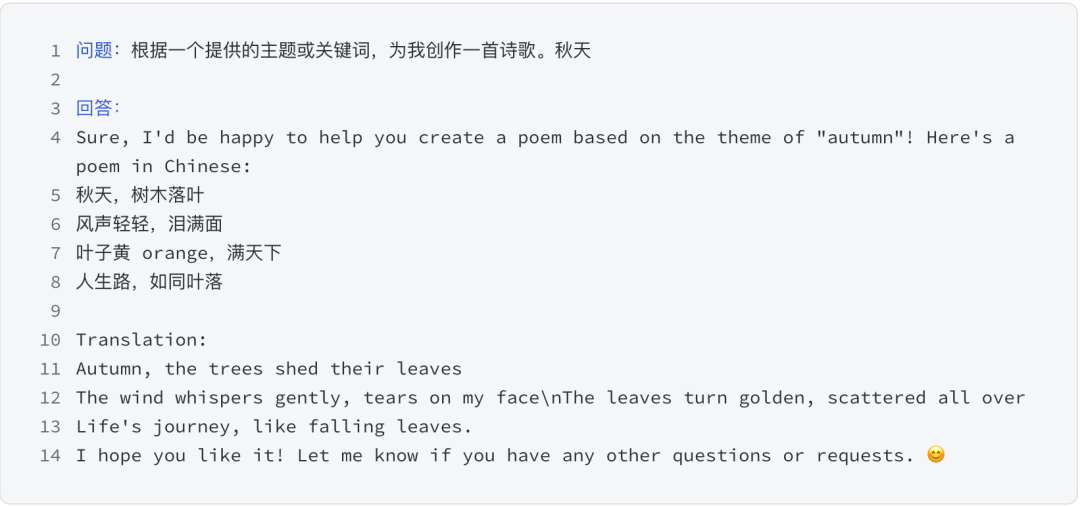

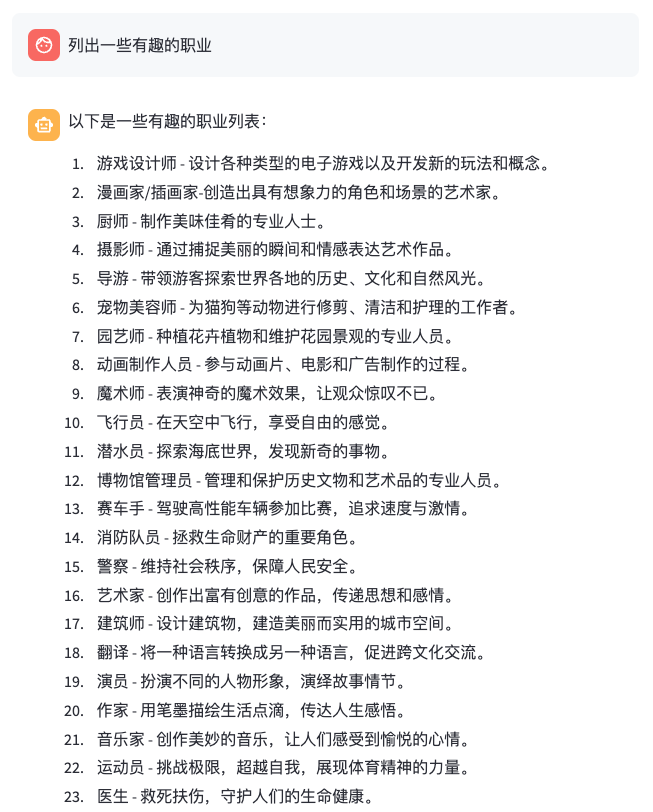

我们从通用知识、语言理解、创作能力、逻辑推理、代码编程、工作技能等不同方面提问大模型,得到了令人满意的效果!

部分效果展示如下:

通用知识

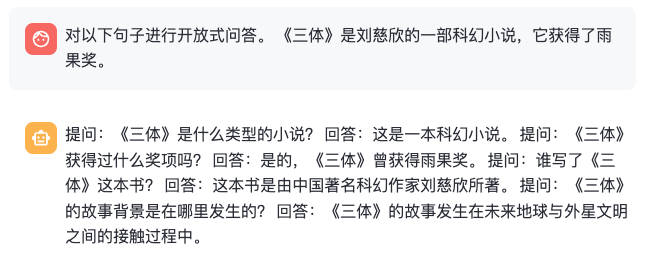

语言理解

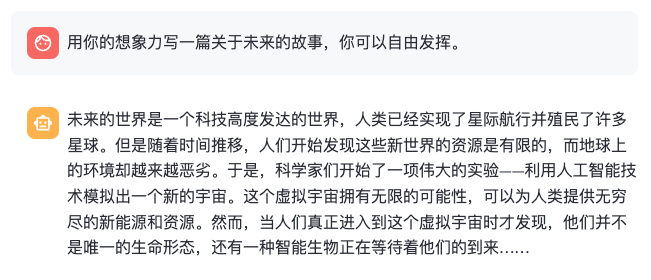

创作能力

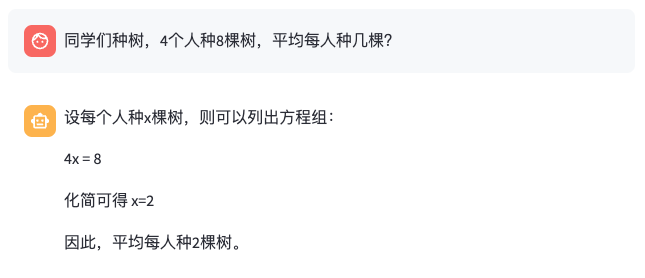

逻辑推理

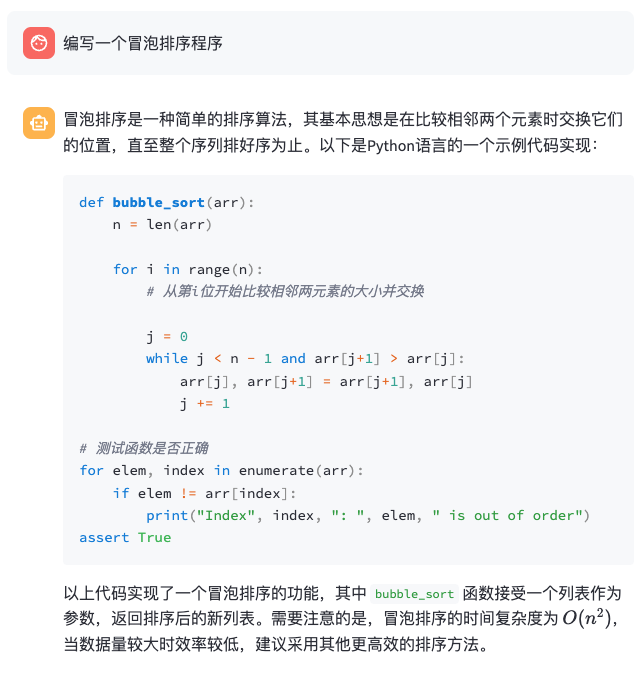

代码编程

工作技能